洪恒飞 科技日报记者 江耘

一张经AI加工的假脸能做什么?可能涉及身份盗窃、隐私侵犯和信息误导等问题。当前,基于生成式人工智能伪造技术的电信网络诈骗手段不断升级,呈现范围扩大化、套路多样化、形式隐蔽化等特点,危害社会安全。

用AI打败AI!科研人员正在开发更先进的AI工具和技术,识别并阻止AI滥用的行为。

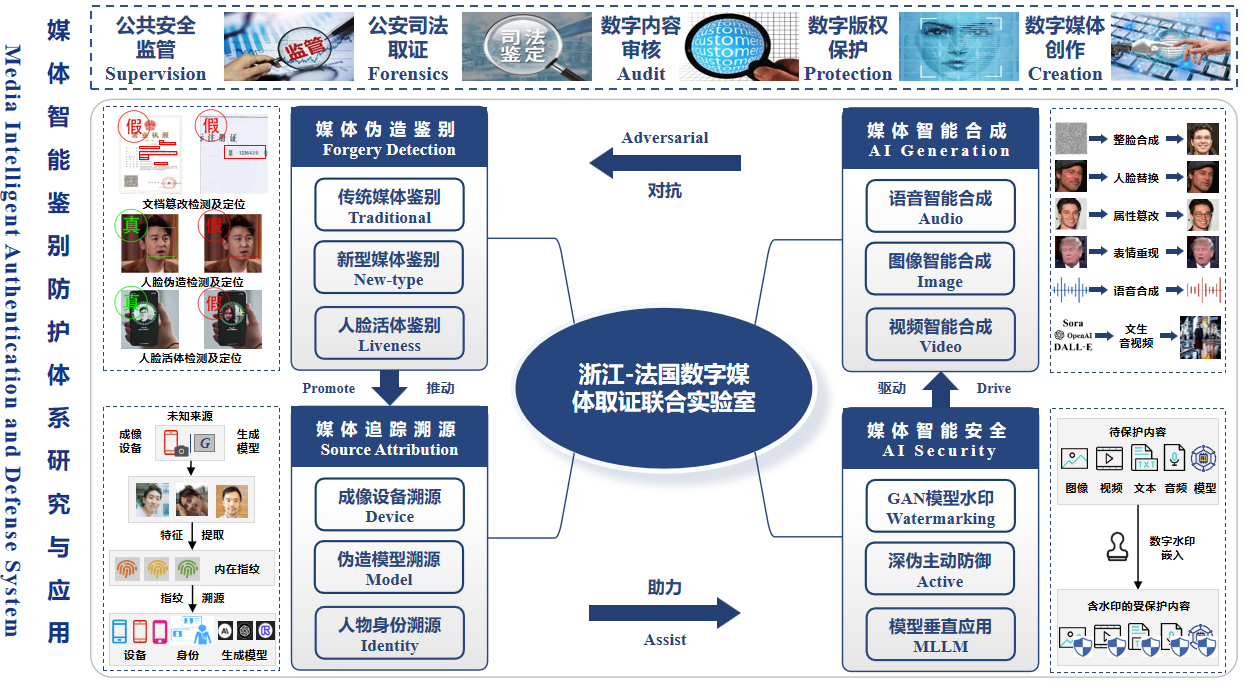

“从以往的PS篡改识别,到如今的AIGC鉴伪,其实是同一类问题的不同形式。”1月15日,在杭州举行的第十三届中国创新创业大赛创新挑战赛(浙江)暨2024年浙江省技术需求“揭榜挂帅”大赛总决赛上,杭州电子科技大学网络空间安全学院、浙江-法国数字媒体取证联合实验室负责人乔通老师展示了团队的“面向电诈场景的音视频鉴伪溯源技术”,强调变被动检测为主动防御。

特殊水印内嵌保护机制

上网搜索“AI换脸”,可见相关应用软件和影音图像比比皆是。与此同时,深度人脸伪造带来的安全威胁逐渐凸显。

此前,中国香港警方披露过一起AI“多人换脸”诈骗案:不法分子利用人工智能深度伪造技术,通过某跨国公司在社交平台的资料,仿造多位高层管理人员的形象和声音,在视频会议中冒充多名人士,诱骗该公司香港分公司财务职员进行转账操作,涉案金额达2亿港币。

针对人脸伪造的“事后鉴别”,即被动取证方法已不鲜见。但被动取证技术由于其“被动”属性,难以及时、有效地遏制伪造人脸图像的传播。为此,主动防御方法由于其“事前防御”的属性,得到越来越多的学者关注。

然而,目前大多数主动防御方法只能针对单一或特定的几种伪造模型进行防御,面对日益多样化和推陈出新的人脸伪造技术,会显得力不从心。

为此,乔通团队开发出了一种可扩展通用对抗性(SUA)水印,将其嵌入在预保护的视频、图像或者语音素材中。当素材被用于AI加工,SUA水印好比一颗触发了引信的隐雷,会直接破坏生成后的内容。

乔通介绍,这一技术路线上,以往单个水印只能针对一种模型,一段素材可能要嵌入多个水印才能起效果。SUA水印则无须基于所有伪造模型进行重新训练,在各种基准数据集上的大量实验验证下,被证明能在消耗更少计算开销的前提下,有效扩展主动防御范围,显著提高主动防御效果。

活体检测配置火眼金睛

去年9月,杭州公安通报了一起典型案例:杭州网警发现,有不法分子使用AI换脸大模型突破头部平台人脸认证,窃取用户隐私信息。

“登录银行或者其他APP时,用户会被要求做摇头、眨眼的动作,即进行人脸活体检测。”乔通说,不法分子通过黑色产业链,可以获取目标对象的人脸照片、音频素材,伪造多模态媒体素材,然后实施诈骗。

平台进行人脸识别前,可以再加一道无形的核验窗口。据了解,针对目前市场上主流的AI伪造工具,该团队开发的AI鉴伪系统,能秒速级识别出AI图像及视频,并给出相应的分析报告,准确率达95%以上。

“相比大型银行,地方中小银行对防伪技术的投入相对不足,但风险管控的重要性更不容忽视。”乔通说,团队目前在和地方公安、小型金融机构等合作,开发定制化技术,相当于在活体检测环节装一副火眼金睛,可判定屏幕那端“是人还是妖”。

需要正视的是,出于防范电信诈骗的目的,部分银行会采取下调个人账户线上相关业务交易限额的举措,虽然有据可依,却给部分用户带来不便,比如出现还房贷困难、大额度商业交易受限等情况。2025年初,国内若干银行宣布下调手机银行交易限额,以期增强账户资金的安全性。

“化解相关矛盾,关键是要加固人工智能安全底座,让反诈举措更加柔性。”乔通表示,团队正积极对接企业,探索商业化模式。AI鉴伪和深度伪造,是此消彼长的关系。需要更多机构、企业参与,推动AI鉴伪的技术突破和应用落地,共同搭建AI时代的网络安全墙。