科技日报记者 崔爽

随着人工智能技术的加速演进,大模型正沿着“技术摸高”与“工程创新”两条路径并行发展,为千行百业带来前所未有的智能化变革。作为近年来最受关注的开源大模型之一,DeepSeek彻底改写了AI算力需求的游戏规则,不仅凭借高效的工程优化在算力受限环境下实现卓越性能,还推动了大规模专家并行(Expert Parallelism, EP)技术的应用。

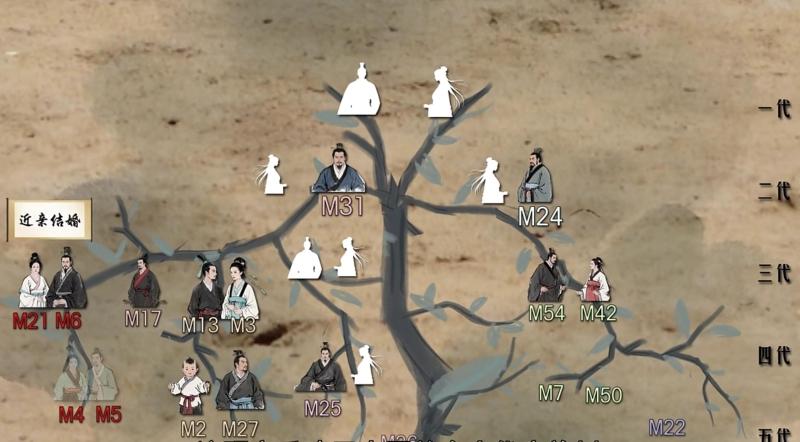

何为大规模跨节点专家并行?据了解,这一技术是将数百个专家(Expert)分布到更多的卡上,减少每张卡权重加载的时延,减少权重的显存占用,能够显著提升单卡并行的路数,每个专家计算路数的提升可以提高矩阵乘的效率,从而实现更大的吞吐和更低的时延。

但与此同时,尽管大规模跨节点专家并行集群推理能够大幅提升性能,在实际应用中却仍面临专家动态均衡与通信时延等挑战。优化负载均衡、缩减通信开销以及高效利用资源,是当前亟待解决的技术难题。

针对这些难题,昇腾发布大规模专家并行推理方案,其通过多专家负载均衡和极致通信优化,实现极致吞吐,单卡性能提升3倍,Decode(解码)时延降低50%+,提升用户体验。

不仅涵盖大规模专家并行方案,昇腾还从预训练、微调、强化学习到推理集群、一体机等,提供了全流程、全覆盖的解决方案。其为业界首个能够复现DeepSeek R1强化学习流程的方案提供商。

据介绍,DeepSeek R1模型采用“每卡部署1-2个专家”的并行模式,结合昇腾双机并行推理与专家负载均衡技术,在稠密模型长序列推理场景中实现了吞吐性能30%的提升。

同时,昇腾AI基础软硬件平台从预训练到推理的全流程支持,使DeepSeek模型在昇腾集群上实现了天级复现。MindSpore框架与昇腾硬件的深度协同,不仅支持模型训练效率提升数倍,更通过优化算子融合和内存管理,充分释放昇腾的异构算力潜能。在长沙人工智能创新中心的部署中,基于昇腾200P算力集群,DeepSeek-R1模型将企业开发成本降低60%,迭代速度提升4倍。

基于此,昇腾与DeepSeek的合作已形成强大生态合力。目前,三大运营商智算平台已全面接入昇腾优化的DeepSeek模型,全国超70%区域可获取服务。在政务领域,广州、深圳、郑州等地的政务云平台已实现基于昇腾DeepSeek模型部署,覆盖智能客服、政策解读等场景。金融、制造等行业头部企业也通过基于昇腾打造的一体机方案,完成模型私有化部署,构建起自主创新的AI基础设施。