科技日报记者 马爱平

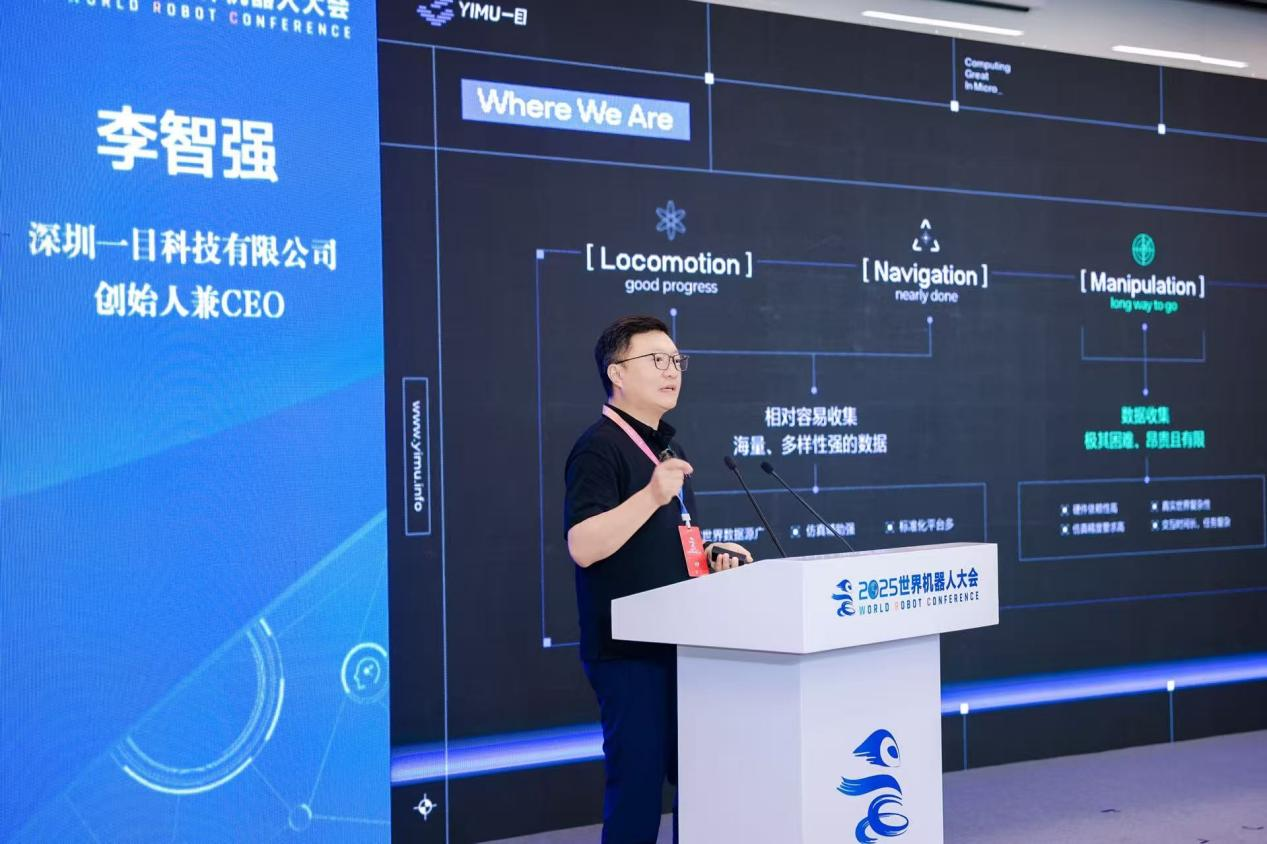

日前,2025世界机器人大会在北京经济技术开发区召开。其间,一目科技创始人兼CEO李智强博士在人工智能大模型赋能机器人与具身智能产业新范式论坛上发表了《触觉增强的世界模型》主题演讲,并发布一目视触觉传感器。

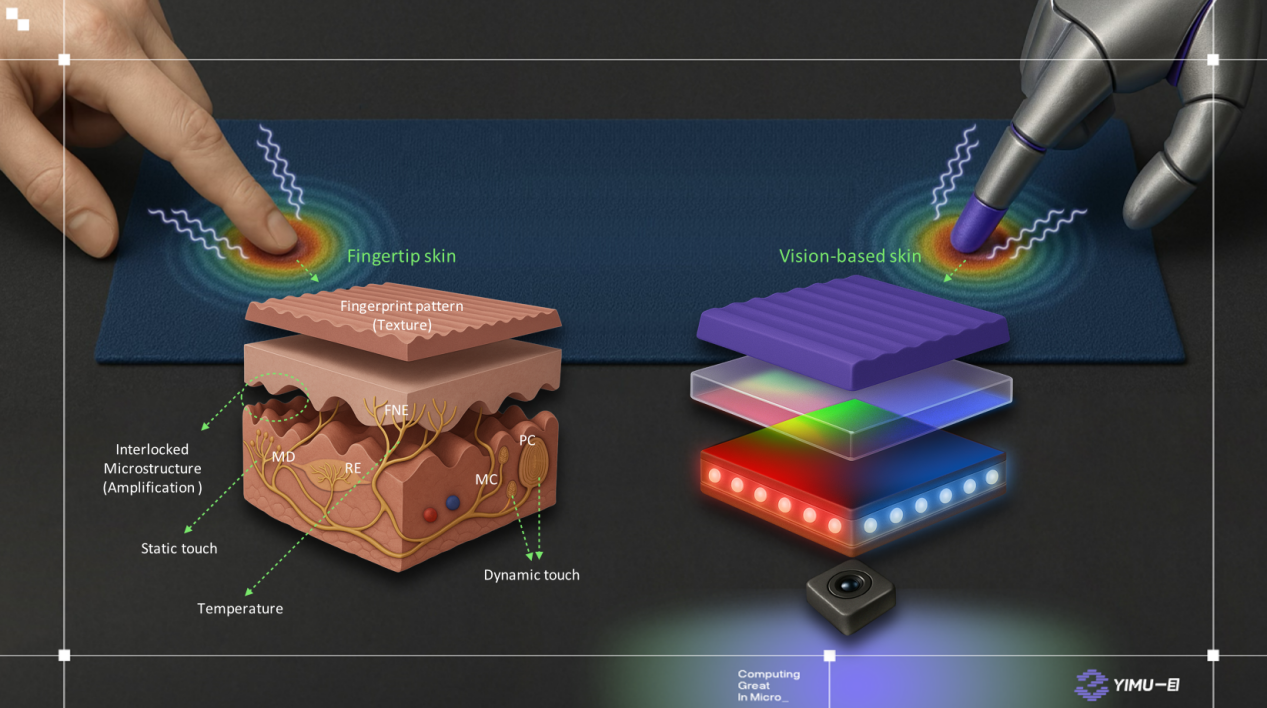

据了解,安装该传感器相当于给机器人装上眼睛——它用摄像头拍下弹性材料接触物体时的细微形变,再把这些变化转化成高清的“触觉照片”。比起只能感知单一压力传感器,它能同时“感受”物体的软硬、纹理甚至滑动趋势。这种高保真的触觉信息,能帮助机器人更精准地“理解”物体特性,像人类一样完成精细操作。

AI大模型筑基具身智能:需补上“触觉感知”课

“对比文本、视觉类大模型,具身智能在物理世界感知能力上仍有明显不足——温度、材质、光滑度等触觉数据的缺失。”李智强在采访中直指核心问题。

他认为,AI大模型要为具身智能筑基,需先解决两大难题:一是数据采集,需通过高保真触觉感知技术,还原人类指尖的多维力学感知能力,收集物理世界的“触觉语言”;二是数据量不足,大模型需要海量数据才能收敛泛化,为此,一目科技提出“以真实触觉信号锚定仿真系统,通过仿真计算生成超真实任务变体数据”的闭环路径,为神经世界模型提供数据“养料”。

通用机器人落地难点:数据量与泛化性需“分而治之”

对于通用机器人在开放场景中实现闭环迭代的最大难点,李智强认为,数据量缺失和场景泛化性不足是两大核心挑战。

“真实世界数据采集效率低,纯靠采样是线性过程,难以满足大模型需求。”李智强表示,其正通过与行业头部企业合作,将触觉仿真能力接入其世界大模型,“通过触觉仿真能力与世界模型的融合,构建‘真实锚定虚拟’的数据闭环,实现物理交互数据的指数级扩增。”

针对场景泛化性,他提出“分而治之”策略:“80%的通用任务(如抓取、放置)由基础模型提供标准化力控接口,实现语义级动作规划;剩余20%高精度场景(如医疗仪器操作),则通过‘技能包’形式提供专业参数配置,让机器人能像下载APP一样‘学会’新技能。”

关于其自研的多传感器融合系统(融合视觉、触觉、力觉等模态),李智强介绍,该系统具有三个特色:一是通用接口设计,可与VLA(视觉-语言-动作)大模型及触觉模型集成,构建VTLA(视觉-语言-动作-触觉)大模型体系,快速接入前沿算法;二是传感器创新,通过微型化与低功耗技术提升触觉信号的保真度;三是材料学突破,团队研发的“仿生皮肤”在耐久性与感知特性上趋近人类指尖,支撑长时间、高精度操作。

产业新形态:从“仪器智能”到“具身智能的操作即服务”

展望未来,李智强认为,具身智能的核心突破将集中在“物理世界与数字世界的深度连接”,传统数字化正在推进,具身智能将进一步扩张维度,让万事万物的物理属性都能被数字模型捕捉。

“正如互联网重构所有行业,具身智能将推动多领域‘重做一遍’——通过物理世界与数字世界的深度耦合,重塑生产流程与服务范式。”李智强说,“从过去十年类人的‘嗅觉、味觉’研究,到未来聚焦的触觉技术,我们始终在复刻人类感知能力,让AI智能体更懂物理世界——这是感知驱动的AI计算终极目标。”

(受访者供图)