科技日报记者 张盖伦

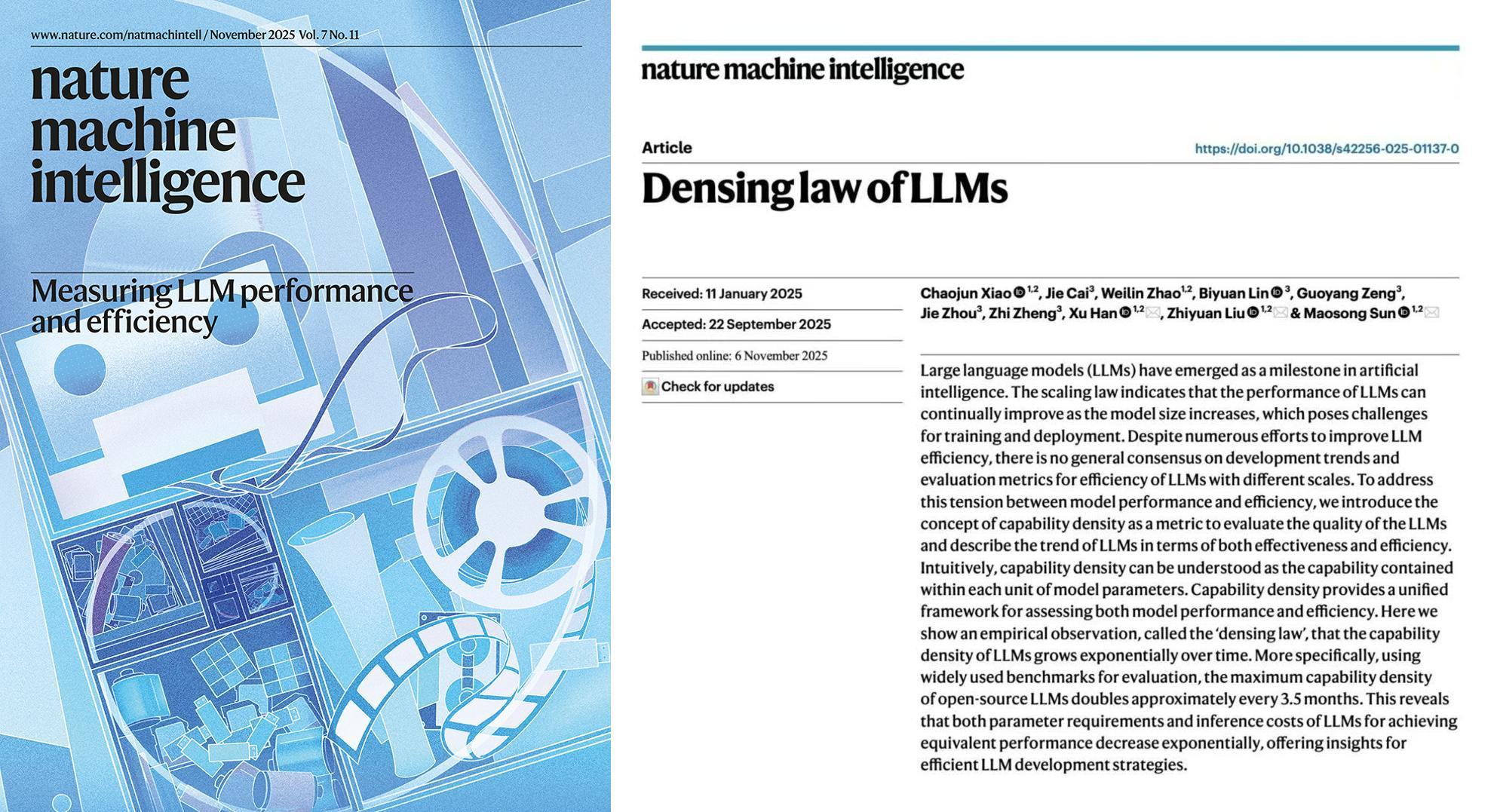

如今,大模型蓬勃发展,有没有指标来衡量AI大模型的“智力能力水平”?近日,清华大学研究团队提出了大模型的密度法则,相关论文刊发于自然子刊《自然·机器智能》上。密度法则揭示大语言模型的最大能力密度随时间呈指数级增长,2023年2月至2025年4月,约每3.5个月翻一倍。

计算机领域的“摩尔定律”大家已经耳熟能详:芯片上可容纳的晶体管数量,每隔一段时间就会翻一番。计算机的强大,不是因为芯片变得像房子一样大,而是因为它在指甲盖大小的面积上集成了天文数字的计算单元。清华大学计算机科学与技术系助理研究员肖朝军告诉科技日报记者,大模型的智力能力水平应该也有一个指标,这就是“能力密度”。

研究的核心假设是,采用相同制造工艺、充分训练的不同尺寸模型,其能力密度相同。正如芯片行业通过提升电路密度实现了计算设备的小型化和普惠化,大模型也在通过提升能力密度实现高效化发展。

肖朝军说,过去,在规模法则的指引下,大家关心一个大模型的“块头”(参数量)有多大,越大就越智能,就像关心一个举重运动员的体重,体重越重,力量越大。现在,密度法则从另一个视角揭示了大模型“高效发展”的规律——我们更应该关心它的“能力密度”,即每一单位“脑细胞”(参数)里包含了多少“智慧”。“如同评价一个武林高手,看的不是他肌肉多发达,而是他一招一式里蕴含了多少功力。”肖朝军说。

研究团队对51个近年来发布的开源大模型进行了系统分析,他们发现了一个重要规律:大模型的最大能力密度随时间呈指数级增长,2023年以来平均每3.5个月翻一倍。这意味着,随着“数据—算力—算法”的协同发展,可以用更少参数实现相同的智能水平。

团队还给出了一些推论。比如,同能力模型的推理开销随时间指数级下降,同时大模型能力密度正在加速增强。ChatGPT发布前能力密度每4.8个月翻倍,而ChatGPT发布后能力密度每3.2个月翻倍,密度增强速度提升了50%。这表明随着大模型技术的成熟和开源生态的繁荣,能力密度提升正在加速。

肖朝军表示,从直观上看,能力密度越高,大模型就越聪明,运行大模型所需要的算力越少,成本就越低。围绕这一科学指引,学术界、工业界能进行多维度的技术创新,让大模型越来越普惠。

从大模型的应用角度来说,密度法则也意味着AI正在变得越来越可用。肖朝军介绍,随着芯片电路密度(摩尔定律)和模型能力密度(密度法则)持续增强,此前只能在云端部署的大模型,未来用终端芯片就装得下、跑得动。大模型跑在终端设备上,在响应速度、用户隐私等方面具备先天优势,可以为用户做得更多。

肖朝军举了个例子。此前大模型在智能汽车上的应用,都是“帮我打开车窗”“帮我查一下附近的餐厅”等“被动式”服务。端侧模型“上车”后,通过丰富的“舱内外感知”和“意图理解”能力,可以实现舱内外环境的多模态感知融合与主动决策闭环,驱动智能座舱从“被动响应”走向“主动服务”,让智能浸润每一次驾驶体验。

(受访者供图)

网友评论

网友评论