科技日报记者 杨雪

2026马年春晚为大家带来一场名副其实的“艺术+技术”盛宴。舞美设计中,AI、AR、XR等技术手段的灵活运用,在虚实之间营造出“人在景中、景随人动”的沉浸立体式视觉效果。大模型首次深度参与到多个春晚节目的创意构思与视觉呈现环节,与导演组、制作团队共同探索了生成式AI在大型舞台艺术创作中的应用边界。

据报道,此次大模型视频生成、图像生成、空间视频等技术支持由火山引擎提供。记者从字节跳动了解到,Seedance2.0推出之前,就在为多个春晚节目进行深度定制,春晚也是Seedance2.0的第一个用户。那么,大模型技术到底如何参与春晚舞台的艺术创作?3D数字分身的奇幻舞台是怎样实现的?“AI互动”是什么,与过去摇一摇抢红包又有啥区别?

第一问:大模型技术如何参与春晚舞台的艺术创作?

以节目《驭风歌》为例,歌手身后的背景是一幅水墨画风格的视频画面。这是本次春晚AI参与度最深、技术挑战最大的节目之一。让水墨风格的素材在舞台背景画中灵动起来,是对模型的国风美学理解和泛化能力的巨大考验。此前,很多国际领先的视频生成模型都难以理解中国水墨画的构图和逻辑,生成视频容易出现变形。

seedance2.0不仅精准保持了水墨画的风格,还保证了素材动态的舒展与自然,做到“形神兼备”。火山引擎相关负责人介绍,这得益于多模态视频生成能力。比如,模型的物理特性遵循,让每匹马的奔跑都遵循自然规律,动作流畅无僵硬感,加速与减速符合物理逻辑,节奏充满力量感与韵律;语义理解能力的显著增强,让模型可以对动作、表情、运镜、文字内容精准执行,精准响应“轻轻地”“再轻一点”等动态副词,根据细节需求调整每个画面;模型能同时处理图片、视频、音频等多种素材,训练中加入大量中国传统文化语料(京剧、水墨、传统绘画),让模型理解水墨艺术逻辑。

在视频生成前,静态的关键帧和分镜设计则由豆包图像创作模型Seedream4.5完成。它能够深刻理解水墨画的艺术风格,并根据导演的草图布局,生成兼具原画神韵与新构图的静态图像,为后续的视频生成提供了高质量“蓝本”。

第二问:3D数字分身的奇幻舞台是怎样实现的?

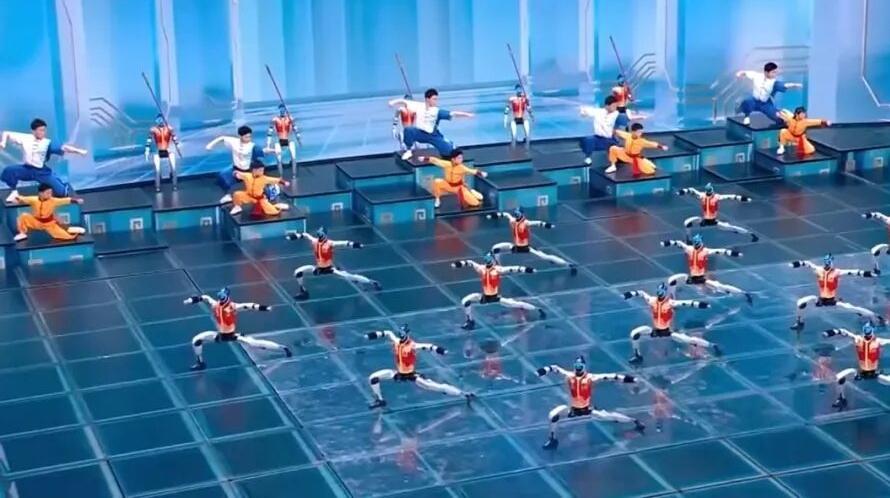

在节目《梦底》中,演员实现了“多个自己”在舞台上不同位置同时表演的震撼场面。当镜头从侧面扫过时,能清晰看到每一个数字分身侧脸的轮廓和光影,而非一张简单的“纸片人”。

这种“真人3D克隆”的视觉效果来自火山引擎空间视频技术。据介绍,首先,演员在专业环绕式采集棚中完成表演,现场的70台工业级高分辨率相机阵列会从不同角度同步捕捉其动态,为后续的四维重建提供高质量、多视角的原始视频数据。然后,这些数据被送入云端,通过火山引擎自研的空间视频4DGS(4D高斯泼溅)重建算法,将演员的表演重建为4D数字资产。最后,这些资产导入Unreal Engine(UE)或Unity等主流游戏引擎,根据现场导播系统和灯光控制台传来的实时数据,进行实时同步渲染,最终将虚实结合的画面输出到直播流中。

虚拟的数字人与现场真实灯光“天衣无缝”的背后,是一套被称为“DMX”的舞台灯光控制协议。火山引擎通过实时转译现场的DMX信号,驱动虚拟场景中的虚拟灯光,使其与物理灯光毫秒级响应,从而渲染出完全同步的光影效果,确保数字人“活”在真实的环境中。

同时,结合豆包的Seed3D和DA3模型:前者提前为演员的每一帧生成一个简化的、不可见的“几何外壳”,渲染时,系统只需计算这个极简“外壳”的影子,计算量大幅降低,渲染效率大幅提升;后者为光影计算提供了极稳定和准确的“先验知识”,从根本上保证了演员在近景下皮肤质感与光影过渡的细腻真实。

第三问:“AI互动”是什么,与过去摇一摇抢红包有啥区别?

传统的互联网互动遵循预设规则——类似一个自动售货机,用户点击一个按钮,系统从预先准备好的货架上取出一个确定的商品。这个结果是有限的、可穷举的,系统只需做好高并发的“存取”操作。

豆包App在春晚提供的AI互动则更像一个能够自由创作的机器人。据介绍,它能先感知、再规划、后行动。首先“听懂”用户的开放式指令,比如“给我生成一个马年头像”“写一段拜年祝福语”等,并能感知多模态的信息,如用户上传自己的图片。接收到指令后,自主“规划”一个复杂的执行链路,例如生成一张图片可能需要依次调用意图理解模型、安全审核模型、图片生成模型等多个模型和工具。最终执行规划,实时生成前所未见的、高度个性化的内容(文字、图片等),并将结果呈现给用户。

这种开放式、实时生成、多模态的特性,正是AI Agent(智能体)的核心能力,也构成了“AI互动”与传统“固定规则交互”的本质不同,为每一个用户,在每一个瞬间,进行一次独一无二的“实时创作”。

网友评论

网友评论